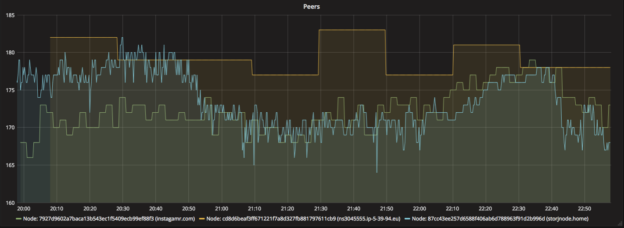

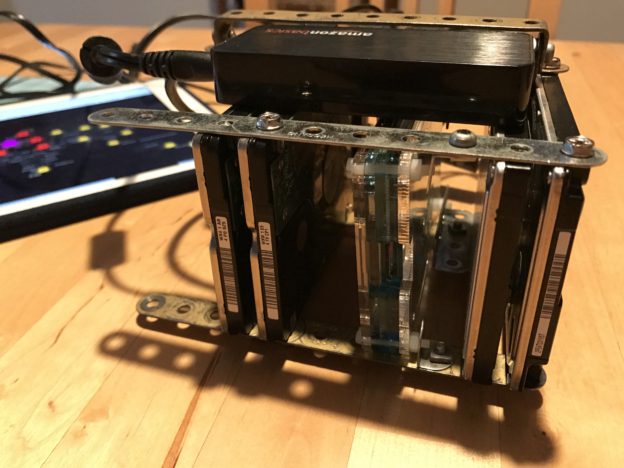

A couple of weeks ago, I put online three Storj farming nodes. Two of them are hosted on my OVH dedicated servers and I even built my own node with Meccano, a Raspberry PI and four old used hard drives. After putting them online, I found myself connecting every day on those three different machines …

Archives de la catégorie : Node.js

Build your own Storj.io farming node with Raspberry and Meccano

EDIT 04-30-2017 After a chat with the community, it seems that running 4 nodes at the same time on a RPI5 is not efficient on uploads peaks. That’s why I updated my setup to use a union filesystem and make storj-daemon see my 4 hard drives as only one. See the setup below… What is …

Continuer la lecture « Build your own Storj.io farming node with Raspberry and Meccano »

Designez des API asynchrones VRAIMENT asynchrones

Je suis tombé récemment sur un vieil article d’Isaac Zimmitti Schlueter à lire ABSOLUMENT. Pour résumer rapidement le propos, IZS explique suite à un avertissement on ne peut plus clair (Do Not Release Zalgo) que lors du design d’une API Asynchrone, il faut éviter à tout prix la situation suivante : Quel est le problème …

Continuer la lecture « Designez des API asynchrones VRAIMENT asynchrones »

Symfony2 MopaBoostrapBundle – Les problèmes fréquents

Ce bundle est parfait pour se lancer dans la réalisation d’une application basée sur le Twitter Boostrap. En revanche, c’est à chaque fois une vrai galère pour l’installer sur un projet sf2 existant. Si vous partez sur une application toute neuve, je vous suggère de jeter un oeil à l’édition Symfony Boostrap hébergée sur ce …

Continuer la lecture « Symfony2 MopaBoostrapBundle – Les problèmes fréquents »